Journal | JFE | A picture is worth a thousand words: Measuring investor sentiment by combining machine learning and photos from news

封面来源:ChatGPT-4 DALL·E

摘要:通过将机器学习应用于基于情绪的准确且经济高效的照片分类,作者引入了从大量新闻照片样本中获得的日度市场级投资者情绪指数(照片悲观度)。与行为模型一致,照片悲观情绪可以预测市场回报逆转和交易量。在恐慌情绪高涨期间,这种关系在套利限制高的股票中最为强烈。此外,本文研究了照片悲观度和新闻文本中蕴含的悲观主义在预测股票收益方面是互为补充还是相互替代,并发现了两者相互替代的证据。

引用:Obaid, K., & Pukthuanthong, K. (2022). A picture is worth a thousand words: Measuring investor sentiment by combining machine learning and photos from news. Journal of Financial Economics, 144(1), 273-297.

Keywords: Investor sentiment; Behavioral finance; Return predictability; Machine learning; Deep learning; Big data.

Introduction

A good sketch is better than a long speech.

—— Napoleon Bonaparte

投资者情绪

投资者情绪理解及预测市场收益(天气与股市收益$\color{blue}{Hirshleifer\ and\ Shumway,\ 2003}$; 运动情绪与股市收益$\color{blue}{Edmans\ et\ al.,\ 2007JF}$; 媒体情绪$\color{blue}{Tetlock,\ 2007JF}$; 实证模型$\color{blue}{Spiegel,\ 2008}$)和横截面股票收益($\color{blue}{Baker\ and\ Wurgler,\ 2006}$; $\color{blue}{Kozak\ et\ al.,\ 2018}$)

贡献

(1)展示视觉内容在预测市场收益方面的重要性:

- 构建日度投资者情绪指数,照片悲观度(PhotoPes),计算为在给定日期预测为负面的新闻照片的比例;

- PhotoPes对第二天的市场回报呈负相关,而与剩余交易周的市场回报率呈正相关;

- 反转凸显了指标对收益的非信息影响;

- 与投资者情绪代理一致,PhotoPes预测次日交易量增加,并更好地预测套利限制高股票的收益。

(2)展示如何通过机器学习技术进行大规模照片分类,克服研究金融市场中视觉内容重要性的关键障碍:

由于现代技术和对快速信息的需求,图片新闻越来越受欢迎(Photojournalism has increased in popularity due to modern technology and the demand for quick information. )

已有研究表明,照片可能比文字更有效地传达情感信息,有鉴于此,作者认为研究从新闻媒体照片中提取的情感与市场活动的关系非常重要($\color{blue}{Chemtob\ et\ al.,\ 1999JTS}$);

- 然而,由于分析照片的复杂性和人工筛选大量照片的成本,类似研究成本高昂、容易出错且繁琐;

- 依靠调查或众包网站(如 Amazon Mechanical Turk、MTurk)评估照片已成为从照片中提取信息的主流方法;经济学家对调查数据也持谨慎态度,因为其主观性过强,无法通过 ”客观的外部测量“验证($\color{blue}{Vissing-Jorgensen,\ 2003}$);另外,$\color{blue}{Singer\ (2002)}$指出,当问题涉及敏感话题且答案取决于受访者的主观意愿时,受访者往往不太愿意认真如实回答问题;

- 使用机器学习方法可以减轻这种担忧(具体而言,作者应用卷积神经网络(CNN)这一常用于照片分类的机器学习技术,对大量新闻照片样本进行了基于情感的准确、可验证且低成本的分类);

(3)比较了PhotoPes和新闻文本中嵌入的悲观情绪的预测能力:

- 实证发现,新闻照片中的悲观情绪和新闻文字中的悲观情绪可以相互替代;

- 照片突出时期,照片能从文字中吸引注意力(在新闻照片绝大多数是负面或正面的时期,新闻照片中的悲观情绪占主导地位。与此相反,当新闻照片是中性或混合性时,文字中蕴含的悲观情绪会占据主导地位);

- 未有文献从新闻图片中捕捉有关投资者信念的有用和新颖信息的可能性,以及这些信息如何与文本中的信息相互作用;

机器学习

金融研究人员已接受机器学习($\color{blue}{Mullainathan\ and\ Spiess,\ 2017JEP}$)

- $\color{blue}{Manela\ and\ Moreira\ (2017JFE)}$00268-3/sbref0047)使用机器学习从WSJ文本中构建新闻隐含波动率指数;

- $\color{blue}{Buehlmaier\ and\ Whited\ (2018)}$通过分析财务报告构建了财务约束的衡量标准,并表明衡量标准与获得资本和股票收益有关;

- 机器学习结合金融数据:

- 预测风险溢价($\color{blue}{Gu\ et\ al.,\ 2020}$00268-3/sbref0037));

- 寻找真正的风险因素($\color{blue}{Feng\ et\ al.,\ 2020}$00268-3/sbref0029));

机器学习新技术引入→→→分析大量照片可行→→→引入CNN从大量新闻照片样本中构建投资者情绪指数

预训练的 Google Inception (v3) 模型

- 该模型未经过专门训练识别情绪,但包含大量有关图像的领域知识;

- 迁移学习(向预训练模型提供由情绪专门标记的额外训练照片样本,并将原始模型的最终全连接层替换为仅含两类感兴趣的新层:消极和积极情绪);

- 该模型考虑了照片的多方面:objects、colors、facial expressions,以做出预测;

- 模型训练后,测试集样本准确率为87.1%;

- 使用该模型对WSJ照片进行投资者情绪预测→→→使用情绪预测构建日度投资者情绪指数(照片悲观度,PhotoPes)→→→给定日期负面照片所占比例;

Data

1926-2018数据来源于Getty Images,日度情绪数据;使用WSJ数据的文献支撑:$\color{blue}{Shiller\ (2015)}$、$\color{blue}{Tetlock\ (2007JF)}$、$\color{blue}{Garcia\ (2013)}$00268-3/sbref0032);

Finding

PhotoPes具有投资者情绪代理的特征

- 首先,检验PhotoPes与美国主要股指和交易所交易基金(ETF)的关系:

- $\color{blue}{De\ Long\ et\ al.\ (1990JPE)}$行为模型预计投资者情绪应当预测市场收益反转【当情绪高(低)时,非理性投资者将增加(减少)他们对资产的需求,从而推高(下跌)价格,偏离基本面。但由于套利的限制 1;$\color{blue}{Pontiff\ (1996QJE)}$、$\color{blue}{Shleifer\ and\ Vishny\ (1997JF)}$】;然而,随时间推移,理性的投资者将利用错误定价,导致价格回到基本水平。

- PhotoPes与次日市场收益呈负相关,与剩余交易周的市场收益呈正相关。该反转凸显了本文衡量标准对收益的$\color{red}{非信息性影响}$;

- 其次,照片悲观情绪与文字悲观情绪(TextPes)显著相关

- 表明这两个变量所捕捉的信息类型存在一些共性;

- 研究照片和文本中蕴含的悲观情绪如何相互作用后,发现新闻照片中的悲观情绪和新闻文本中的悲观情绪可以相互替代;

- 实证表明$\color{red}{在照片显著的时期,照片会从文字中捕获注意力}$。

- 第三,深入了解新闻和金融市场背景下,哪类信息通过照片传播更有效:

- 相较基线时期,恐惧情绪高涨时期照片中蕴含的悲观情绪的系数大两倍以上,而文本信息的系数则基本保持不变。即与文字相比,照片在传递创伤性新闻方面更为有效($\color{blue}{Chemtob\ et\ al.,\ 1999JTS}$);

- 高度恐慌时期,照片对市场收益的影响最为显著;

- 第四,进一步验证PhotoPes作为投资者情绪代理的有效性,表明其对难以套利的股票影响更大:

- 基于套利成本高的股票对投资者情绪冲击最敏感的预测($\color{blue}{Baker\ and\ Wurgler,\ 2006}$),本文构建基于firm idiosyncratic volatility和size的投资组合;

- 实证发现,PhotoPes对idiosyncratic volatility最高和size最小投资组合的收益影响最大;

- 第五,更好地理解PhotoPes与市场回报相关的渠道:

- PhotoPes值的高低可预测次日异常交易量的增加,该证据进一步验证PhotoPes能够捕捉投资者情绪($\color{blue}{De\ Long\ et\ al.,\ 1990JPE}$);

- 最后,稳健性检验表明,即使在控制了极端收益之后,主要结果对不同的可变结构标准仍然可靠,PhotoPes生成了显著样本外$R^2$;

1. 有限套利或称套利限制是指由于风险、成本、信息不对称和制度性约束等因素的影响,使得套利者的套利行为受到限制。 ↩

文献扩展

与投资者情绪文献相关

- 鉴于投资者情绪的多维性,研究人员一直在寻找不同的方法来衡量投资者情绪($\color{blue}{Zhou,\ 2018ARFE}$);

- 使用新闻($\color{blue}{Tetlock,\ 2007JF}$)、谷歌搜索数据($\color{blue}{Da\ et\ al.,\ 2015RFS}$)、推特数据($\color{blue}{Chen\ et\ al.,\ 2014RFS}$)、公司财务报告($\color{blue}{Loughran\ and\ McDonald,\ 2011JF}$;$\color{blue}{Jiang\ et\ al.,\ 2019JFE}$)、天气($\color{blue}{Hirshleifer\ and\ Shumway,\ 2003JF}$)和体育赛事($\color{blue}{Edmans\ et\ al.,\ 2007JF}$)代表投资者情绪($\color{blue}{Hirshleifer,\ 2001JF}$);

扩展投资者情绪和新闻文献

- 新闻是投资者信念的可信替代物,因为新闻界有需求方动机来迎合读者的信念($\color{blue}{Shiller,\ 2005IE}$)。

- $\color{blue}{Mullainathan\ and\ Shleifer\ (2005AER)}$总结了传播学、心理学、记忆和信息处理方面的文献,这些文献支持人们从与其信念一致的内容中获得效用的观点;

- $\color{blue}{Gentzkow\ and\ Shapiro\ (2010Econ)}$为这一理论提供了实证证据,具体而言媒体的倾向性在很大程度上归因于消费者的偏好;

- $\color{blue}{Tetlock\ (2007JF)}$的$\color{blue}{Garcia\ (2013JF)}$00268-3/sbref0032)研究表明,新闻文本中蕴含的情绪可以预测市场收益和交易量;

- 本文通过揭示新闻照片中包含与金融市场相关的内容,进一步扩展文献;

将视觉刺激心理学文献扩展到金融和经济学

关于新闻中视觉刺激的证据不一

一方面,图片优势效应($\color{green}{picture\ \ superiority\ \ effect}$)是心理学中的一个已知概念,是指图片比文字更容易被回忆起的现象($\color{blue}{Nelson\ et\ al.,\ 1976JEPHLM}$;$\color{blue}{Paivio,\ 1991Book}$);

- $\color{blue}{Newhagen\ and\ Reeves\ (1992JoC)}$将图片优势效应延伸到了新闻媒体,发现新闻中的视觉内容比新闻中的文字内容更容易被回忆;

- 此外,$\color{blue}{Garcia\ and\ Stark\ (1991Book)}$以及$\color{blue}{Powell\ et\ al.\ (2015JoC)}$发现,图片在新闻中起到吸引注意力的作用;

另一方面,研究人员发现,当信息简单易懂时,视觉内容最为有效,而当信息复杂时,文字内容最为有效($\color{blue}{Chaiken\ and\ Eagly,\ 1976JPSP}$);

- 本文以金融决策为背景,对以上两方面文献进行调和;

扩展关于视觉内容预测金融市场

- 一些研究记录了一张照片如何能够预测重要结果,如政治选举、个人贷款决策、公司市值和首席执行官薪酬( $\color{blue}{Todorov\ et\ al.,\ 2005Science}$;$\color{blue}{Duarte \ et\ al.,\ 2012RFS}$;$\color{blue}{Halford\ and\ Hsu,\ 2020FR}$;$\color{blue}{Graham\ et\ al.,\ 2017MS}$);

- $\color{blue}{Bazley\ et\ al.\ (2021MS)}$记录了用红色显示财务信息如何降低投资者的风险偏好和乐观情绪;

- $\color{blue}{Blankespoor\ et\ al.\ (2017JAR)}$展示了视频演示中对管理层的看法与公司价值的关系;

- 本文首次利用机器学习从新闻照片中开发出投资者情绪代理预测股市收益;

Data

Photo classification

机器学习照片分类模型的主要任务是能够在最少人工参与的情况下识别照片内容

- CNN 是一种深度神经网络,可用于照片分类($\color{blue}{Krizhevsky\ et\ al.,\ 2012ANIPS}$),最近的研究利用CNN照片分类模型:

- 通过分析卫星图像识别太阳能电池板的安装($\color{blue}{Yu\ et\ al.,\ 2019Jonle}$30570-1.pdf))、奴隶营的位置($\color{blue}{Scoles,\ 2019Science}$)以及欠发达国家的贫困程度($\color{blue}{Jean\ et\ al.,\ 2016Science}$);

- 与本文类似,$\color{blue}{You\ et\ al.\ (2015PAAAICAI)}$也采用 CNN 进行图像情感分析,并在社交媒体的照片上取得了很高的准确率;

构建能够预测照片可能引发投资者情绪的模型

基于Google Inception (v3) ($\color{blue}{Szegedy\ et\ al.,\ 2016PIEEECCVPR)}$建立一个照片分类模型

TensorFlow是谷歌大脑团队开发的一个开源软件库,是机器学习应用的常用工具,提供了一个预训练的谷歌 Inception (v3) 模型

- 从预训练Google Inception (v3) 模型(在ImageNet数据集上训练)入手,利用迁移学习针对本文特定应用对模型进行微调;

- 预训练的Google Inception (v3) 有1000个不同的类别,其初始目的为:ILSVRC;

- 【从头开始训练照片分类模型需要大量的训练样本,而且计算成本很高,133 1167 张预先标记的图片训练而成】通过迁移学习,重新利用预训练模型中存储的领域知识,只需将最后的全连接层替换为具有所需类别数量的新层,并用更少的训练样本重新训练最后全连接层的参数,轻松构建出本文所需模型($\color{blue}{Yang\ et\ al.,\ 2013ML}$);

- 微调模型输出照片具有正面情感的概率和照片具有负面情感的概率;

2. 在来自ImageNet数据集的验证集上,前五名和前一名的错误率分别为 3.5% 和 17.3%。前一错误率是指模型没有将正确类别作为其最高预测概率的时间百分比。前五名错误率是指该模型未将正确类别作为其概率排名前五的预测结果的时间百分比。 ↩

3. ImageNet 数据集可在以下网址免费下载: http://image-net.org/download 。 ↩

未开发更精细分类模型原因

- 首先,更精细的分类需要主观判断。大多数文本情感分析,如$\color{blue}{Loughran\ and\ McDonald\ (2011JF)}$的分析,都是对词语进行二元分类(如正面词语和负面词语) 4。

- 其次,本文尝试创建一个具有更精细类别的照片分类模型,但模型无法收敛,因为其无法检测出不同细分类之间的明显区别。

4. 例如,“疾病”和“崩溃”显然是负面的,但其负面程度却不太明显。语境和个人对单词本身的主观解释也会影响负面情绪的程度。 ↩

迁移学习

- 迁移学习需要一个由情感标签照片组成的训练集。

- 本文使用DeepSent数据集进行训练 5, 由$\color{blue}{You\ et\ al.\ (2015PAAAICAI)}$收集并按情感标记的照片集。

- 使用DeepSent数据集的主要优势在于,情感标签是通过众包网站(如MTurk) 验证的,以确保标签的正确性 6。【为了提高可靠性,作者使用MTurk调查的所有五位参与者都同意照片情感的照片。这一限制将训练样本减少到 882 张照片。】

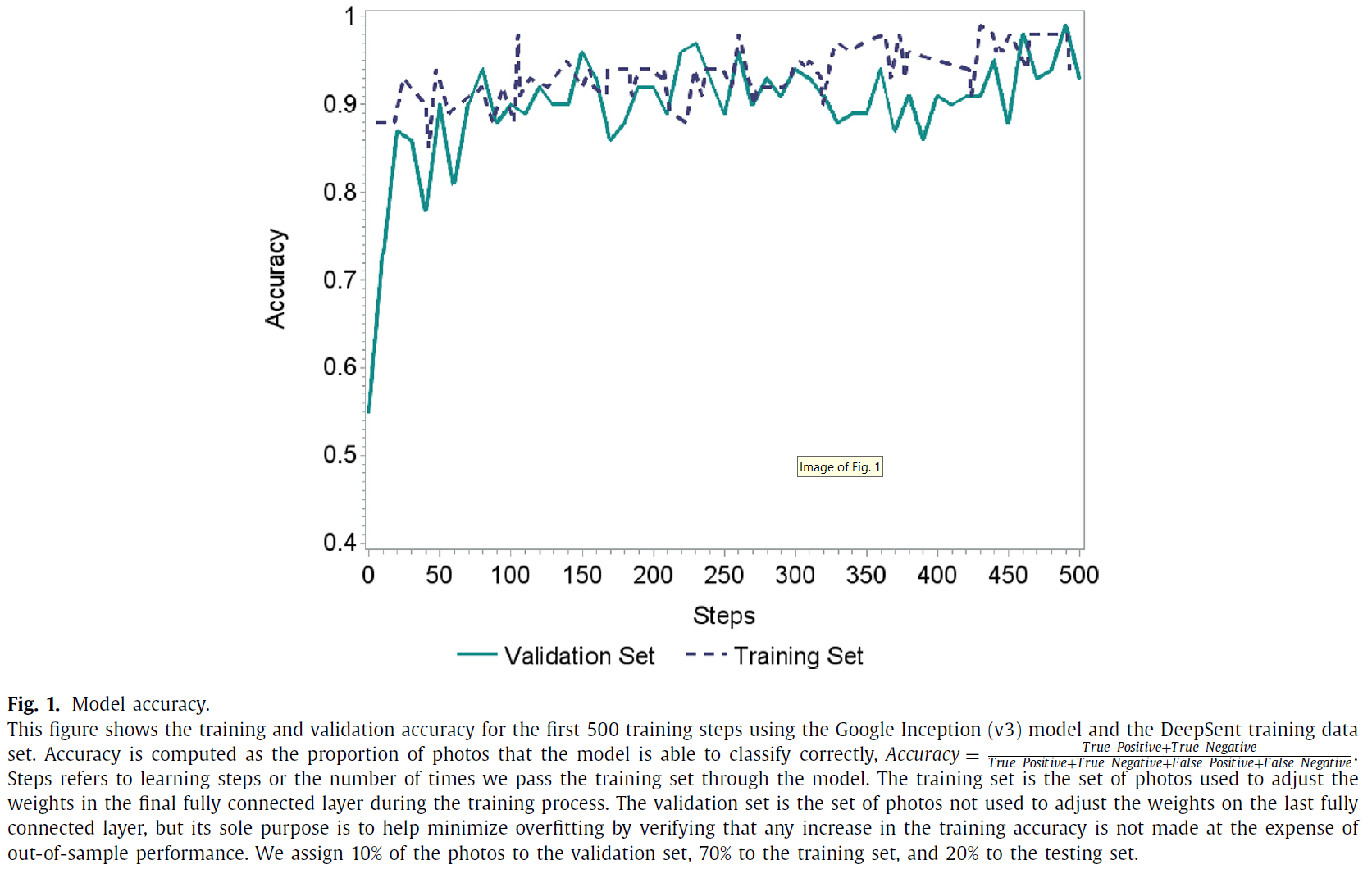

- 该模型使用0.01的学习率和500个学习步骤进行训练 7。将训练批次大小设置为100张照片,保留10%的训练照片作为验证样本,20%的训练照片作为测试样本(照片随机分配到各集合) 8。

- 训练集是训练过程中用于调整最终全连接层权重的照片集。验证集是一组照片,不用于调整最后一个完全连接层的权重,但它们的唯一目的是通过验证训练准确性的任何提高不会以牺牲超出的代价来帮助最大限度地减少过度拟合。样本性能。最后,测试集是模型在训练过程中从未见过的一组照片,用于计算模型的最终准确度得分。除了使用验证集来限制过度拟合之外,我们还通过使用增强技术(例如翻转、缩放)并在模型中添加正则化技术(例如 dropout 和标签平滑)来扩大训练集(Szegedy 等人,2016)。

- 训练集是在训练过程中用于调整最后全连接层权重的照片集。验证集是不用于调整最后全连接层权重的照片集,但其唯一目的是通过验证训练精度的提高是否以牺牲样本外性能为代价,从而帮助最大限度地减少过拟合。最后,测试集是模型在训练过程中从未见过的一组照片,用于计算模型的最终准确率得分。除了使用验证集来限制过拟合外,作者还通过使用增强技术(e.g., flip, scale)以及在模型中添加正则化技术(如dropout and label smoothing )来扩大训练集($\color{blue}{Szegedy\ et\ al.,\ 2016PIEEECCVPR}$)。

5. Deep Sent 包含 1269 张带标签的照片,可供下载:https://qzyou.github.io/#datasets。 ↩

6. 验证标签的过程是一项昂贵且耗时的任务。然而,不验证标签可能会导致模型性能不佳,因为训练数据可能有噪音,因此我们采取额外的步骤来确认标签。 ↩

7. 学习率是模型中的权重在每个学习步骤之后可以改变的量。学习步骤是指我们通过模型传递训练集的时间。这些是 CNN 图像分类应用中使用的常见值($\color{blue}{You\ et\ al.,\ 2015PAAAICAI}$)。 ↩

8. 作者避免使用大部分训练样本作为测试集,以确保训练集中有足够的照片。文献中存在一些差异,但大多数研究将大部分样本分配给训练集(通常在70%到80%之间),其余样本分配给验证集和测试集。例如,$\color{blue}{Yu\ et\ al.\ (2019Jonle)}$30570-1.pdf)使用77/3/20分割。 ↩

模型检验(测试集)

$\color{blue}{图1}$绘制该模型在训练步骤中的训练和验证准确率。测试准确率达到87.1% 9,该值与文献中其他照片情感分类模型的准确率相似。例如,$\color{blue}{Campos\ et\ al.\ (2017)}$比较了在 DeepSent上训练的CNN模型的各种修改,并报告了测试集准确率值,其范围在78.3%到83.0%之间。为了更好地测试本文模型性能,作者还计算了召回率(86.2%)、精确率(94.3%)和 F1(90.1%) 10。

(精确率衡量了模型在所有预测为阳性的照片中识别阳性照片的准确度(当假阳性的成本很高时,这是一个重要指标)。Recall 衡量模型从样本中所有阳性照片中识别出阳性照片的准确度(当假阴性的代价较高时,这是一个重要指标)。F1 是精确度和召回率的调和平均值。)

9. 我们避免使用大部分训练样本作为测试集,以确保训练集中有足够的照片。文献中存在一些差异,但大多数研究将大部分样本分配给训练集(通常在 70% 到 80% 之间),其余样本分配给验证集和测试集。例如,$Accuracy = \text{(True Positive + True Negative) / + (True Positive + True Negative + False Positive + False Negative)}$ ↩

10. $Recall = True positive / (True Positive + Falese Positive)$,$Precision = True Positive / (True Positive + False Positive)$,$F_1 = 2 Recall Precision / (Recall + Precision)$ ↩

模型检验(人工标注WSJ数据)

问题:DeepSent训练集中的照片来自社交媒体,可能与 WSJ 样本中的专业新闻照片类型不太相似,使用 DeepSent训练集训练的模型可能无法对专业照片进行准确分类。

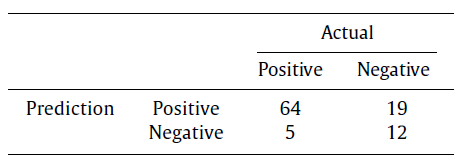

解决:从WSJ样本中随机选取100张照片,并对每张照片进行分类(分类工作由五个人在MTurk中预先完成) 11。通过模型对照片进行预测,并将预测结果与从MTurk收集到的回复进行比较。作者将分析结果总结为以下混淆矩阵 12:

根据上述混淆矩阵,计算模型在对WSJ的专业新闻照片样本进行分类时的表现。准确率为 76.0%;召回率为92.8%;精确率为77.1%;F1为84.2%。鉴于样本中存在不平衡的类别,因此关注F1至关重要。准确率、召回率、精确率和 F1 数值与$\color{blue}{You\ et\ al.\ (2015PAAAICAI) }$基于使用DeepSent数据集训练的照片分类算法所报告的数值接近(他们的结果汇总见 $\color{blue}{You\ et\ al.\ (2015PAAAICAI) }$的表1)。总体而言,该表显示本文使用DeepSent训练集训练的模型在新闻照片分类方面表现良好。

11. 要求 MTurk “员工”的 HIT 通过率超过 95%,并且必须位于美国。 ↩

12. 在机器学习领域,混淆矩阵是总结分类模型性能的常用方法。表中的数字代表测试样本中属于true positives, false positives, false negatives, and true negatives这四个类别的照片数量。 ↩

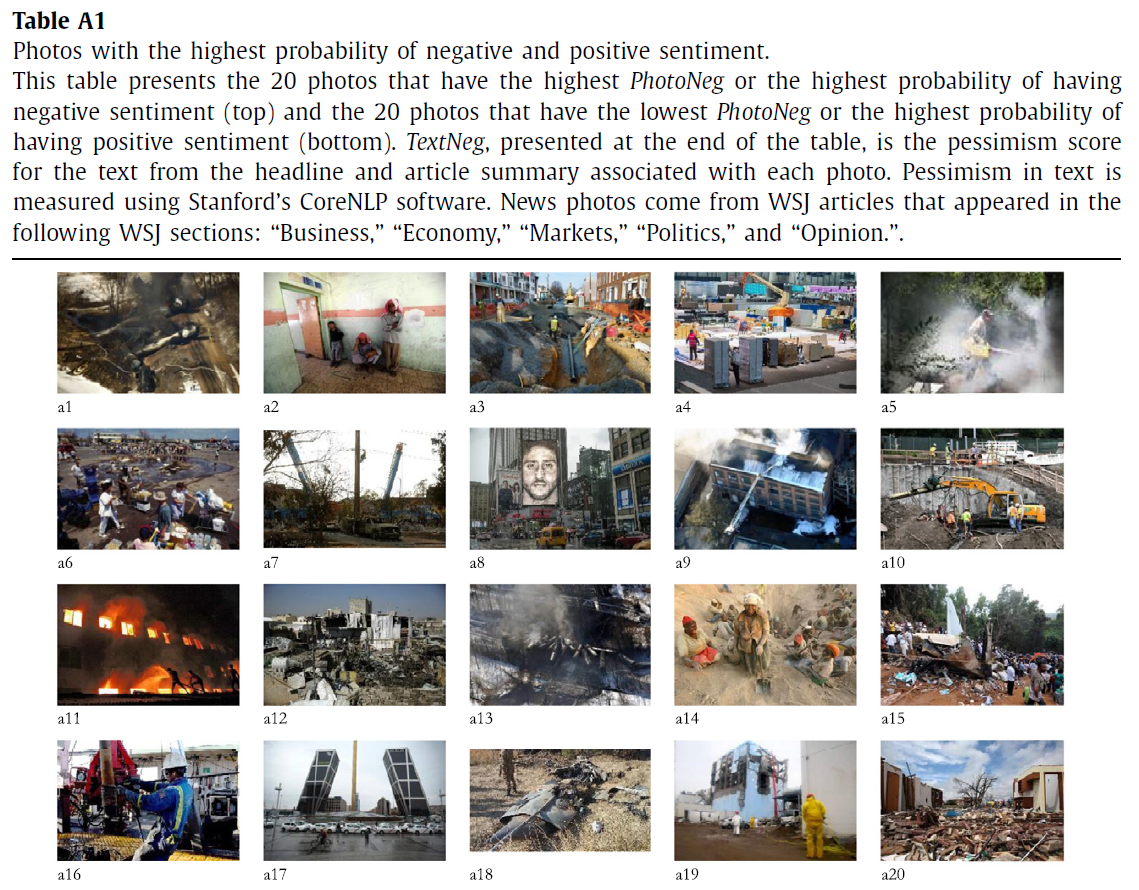

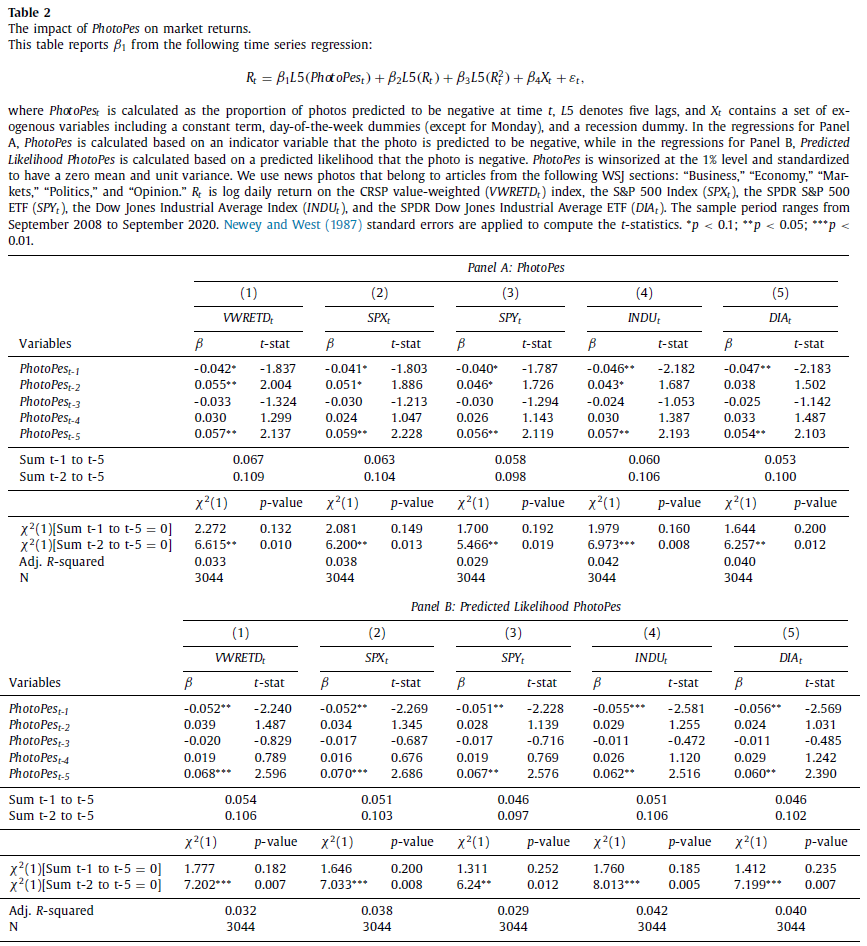

$\color{blue}{附录表A1}$列出了样本中被预测为具有最高负面(顶部)或正面(底部)情绪概率的前 20 张照片。$PhotoNeg_{it}$是第$i$张照片在第$t$天出现负面情绪的概率。总体而言,这些示例照片有助于确认照片分类模型的正确运行。

The Wall Street Journal sample

WSJ关注重大事件,目标受众是对经济和金融市场特别感兴趣的读者。WSJ为订户提供在线访问过去文章的服务,最早可追溯到1997年12月。但是,2008年9月之前的文章很少附带照片。缺少2008年9月之前照片的原因之一是,《华尔街日报》并不拥有许多照片的版权,而是从Associated Press, Reuters, and Getty Images等其他新闻和媒体机构获得了照片的有限授权。一旦许可证到期,照片就会被删除。

从WSJ的2008年9月至2020年9月期间以下版面收集了每篇文章的标题和摘要、相关照片以及文章发表的时间戳:“Business,” “Economy,” “Markets,” “Politics,” and “Opinion”。只要是与经济相关的国际话题(如 “Asia Business”)均会收录,这些栏目报道与公司或行业相关的重大事件以及总体市场状况。

共收集148823篇文章,时间跨度为3048个交易日。使用第2.1节中讨论的照片分类模型对这些照片进行情感分类。

Variable construction

$PhotoPes$

主要变量”$PhotoPes$”的计算方法为:预测在特定日期为负数的照片所占比例。第$t$天的$PhotoPes$计算公式为:

其中$Neg_{it}$是一个指标变量,表示第$t$天的照片$i$是否会产生负面情绪。分母$n_t$对应的是$t$日的照片数量。网站(https://www.kuntara.net/)提供相关数据。

$PhotoPes$并非简单的二元衡量标准。虽然单张照片被分为负面或正面,但$PhotoPes$是一个连续的测量值。与负面照片较少的日子相比,负面照片较多的日子的$PhotoPes$值较高,这与文献中许多情感度量方法的理念相同。本文使用另一个版本的$PhotoPes$展示基线结果,该版本使用预测可能性 ($PhotoPes$)代替指标变量$Neg{it}$。$\color{blue}{表 2\ Panel\ B}$显示,结果一致。如果将指标变量 ($Neg{it}$) 的临界值从50%调整到 55%,结果一致

)的临界值从 50% 调整为 55%,我们的结果仍然成立($\color{blue}{表A 2\ Panel\ A}$)。

$TextPes$

本文目标之一是比较照片和文字中蕴含的悲观情绪。受$\color{blue}{Manela\ and\ Moreira\ (2017JFE)}$00268-3/sbref0047)以及$\color{blue}{Cong\ et\ al.\ (2018SSRN)}$的启发,作者分析了文章的标题和摘要。从概念上讲,用来识别照片中悲观情绪的机器学习方法包括特征之间的高度非线性关系。为了便于对照片和文本中的悲观情绪进行公平比较,避免使用词典方法对文本进行分类。相反,使用斯坦福大学CoreNLP软件中的情感工具来评估每个句子中的悲观情绪,并将文本中所有句子的平均悲观情绪得分作为文章的悲观情绪得分,即$TextNeg$(来源:https://stanfordnlp.github.io/CoreNLP/)。

该情感工具以递归神经张量网络(RNTN)为基础,在包含215154个短语的数据集上进行训练,这些短语带有细粒度的情感标签(标度:{“ 负面 “ = 1; “ 中性 “ = 0.5; “ 正面 “ = 0})。该RNTN模型在短语方面表现尤为突出,短语准确率高达 85.4%($\color{blue}{Socher\ et\ al.,\ 2013PCEMNLP}$)。由于WSJ文章的标题和摘要部分通常都很简短,因此该工具非常适合。$TextPes$的计算公式如下:

其中$TextNeg_{it}$是CoreNLP模型中第$t$天每篇文章$i$的悲观分数。分母$n_t$对应于日期$t$中的文章数量。$PhotoPes$和 $TextPes$进行1%水平缩尾处理。结果在不进行缩尾处理的情况下保持不变($\color{blue}{表A 2\ Panel\ B}$)。

基于RNTN方法而不是基于字典的方法,原因如下:

- 首先,本文用来识别图像中情感的方法包含了特征之间的高度非线性关系,而对文本采用基本方法会让图像捕捉到更微妙的情感特征,从而使结果对作者有利,而对文本采用简单的方法则无法捕捉到这些情感特征。例如,字典方法对“好”和“很棒”等积极词给予相同的权重,并且不考虑上下文和单词组合,而RNTN方法则考虑这一点,因此使用具有相当复杂性的方法提取情感合适。

- 其次,本文分析的是文章的标题和摘要部分,比全文短得多。字典方法最适合10-K或完整新闻稿等长文本,因为其避免任何单词与字典中的单词重叠的情况($\color{blue}{Loughran\ and\ McDonald,\ 2011JF}$)。本文数据中92.47%的文章标题和摘要部分不包含任何属于Loughran和McDonald词典的净负面或正面词汇。相比之下,使用机器学习方法,只有63.66%的标题和文章摘要部分包含中性情绪。

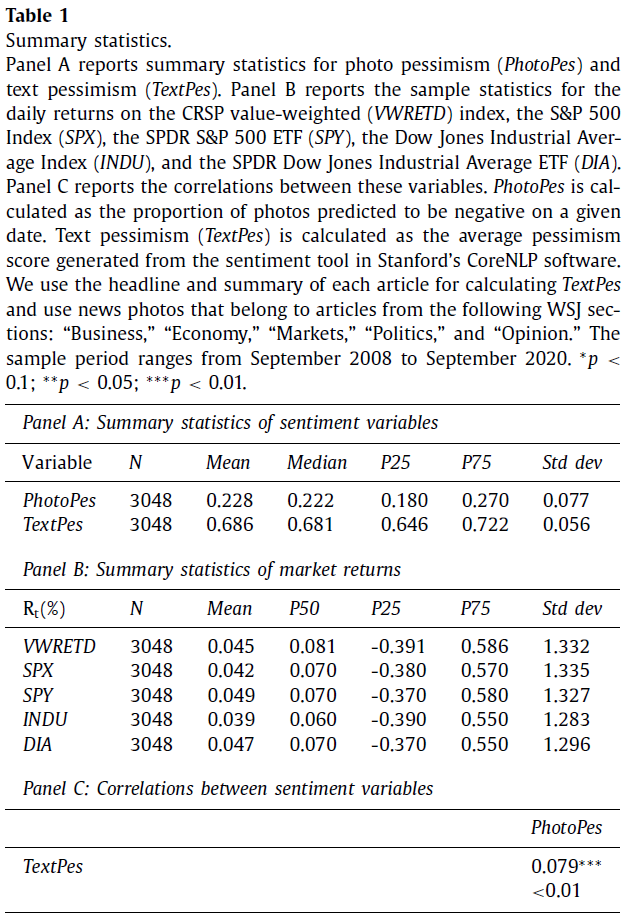

Descriptive statistics

$\color{blue}{表1\ Panel\ A}$报告了悲观变量的汇总统计量。从2008年9月到2020年9月,有3048个交易日。平均而言,$PhotoPes$为 0.228,即22.8%的照片在某一天会出现负面情绪。平均而言,$TextPes$为0.686,表明平均而言,文章的标题和摘要文本由负面句子组成(Scale:{“Negative”= 1;”Neutral “= 0.5;”Positive”= 0})。所有变量都有明显的一阶自相关性,因此具有持久性(在测试中解决了自相关性问题)。

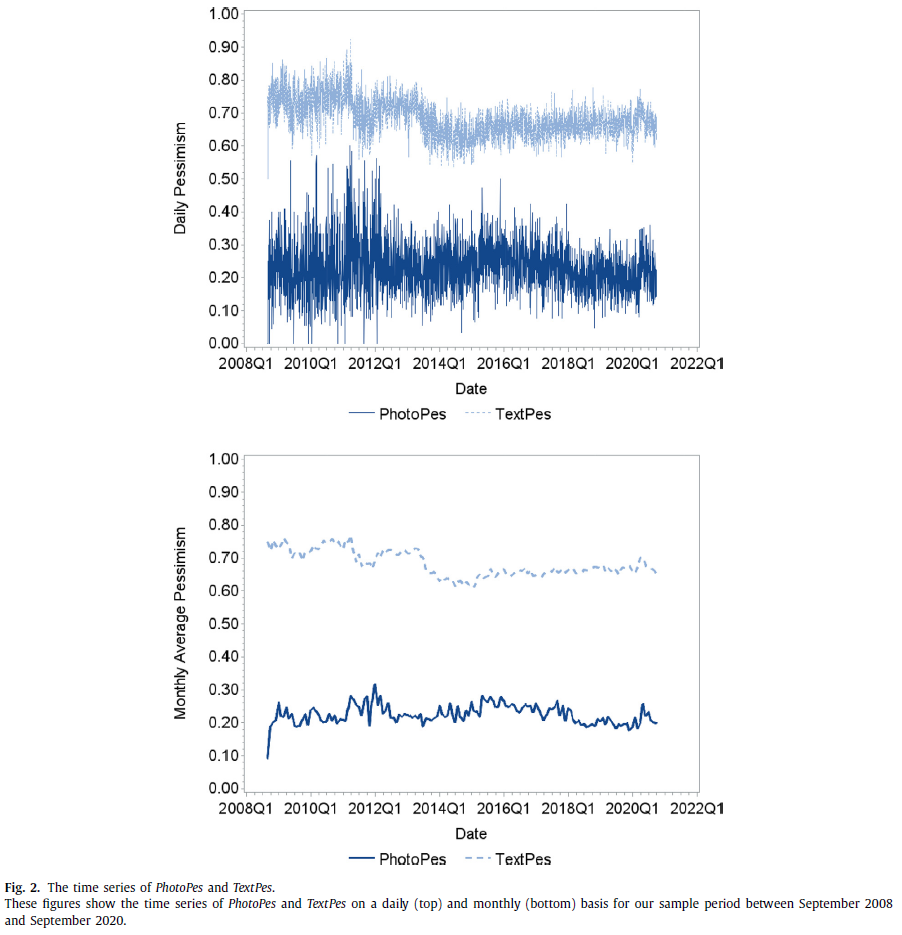

$\color{blue}{表1\ Panel\ B}$报告主要美国股指和ETF的汇总统计数据。$\color{blue}{表1\ Panel\ C}$报告了$PhotoPes$与$TextPes$的关系。计算$PhotoPes$和$TextPes$之间的成对相关性和对应$p$值,$PhotoPes$和$TextPes$呈正相关(相关系数=0.079,$p$值 < 0.01)。然而,相关性不是很高,这表明照片中存在的一些信息与WSJ文章标题和摘要部分中的文本不同。在文章层面,62.65%的文章文字和图片语气一致。$\color{blue}{图2}$显示$PhotoPes$和$TextPes$的每日和每月频率的时间序列,在恐慌情绪高涨的时期,包括2008年至2011年的次贷危机和2020年的COVID-19危机,这两个序列都会出现较大的峰值。例如,2011年两个变量的峰值特别大,可以归因于美国与基地组织之间的高度紧张,从美国政府于 2011年5月9日处决基地组织头目就可见一斑。此外,2011年3月11日日本东北地区发生地震和海啸后,美国西海岸也发出了海啸警报。 2011年3月16日,美国食品批发价格上涨3.9%,创1974年11月以来最大单月涨幅。有关通胀失控的传言只会让情况变得更糟。综上所述,重大新闻事件往往伴随着悲观照片,而这些照片正是我们的衡量指标。最后,与正常时期相比,市场动荡时期$PhotoPes$和$TextPes$更加接近 13。

13. 市场动荡期间,$PhotoPes$和$TextPes$之间的相关系数最高。相关性在2008年第四季度达到峰值,约为0.5,然后在 2009年1月下降至0.2。同样,在2020年第二季度,新冠疫情期间,相关性跃升至 0.36。 ↩

Results

行为模型通过做出两个假设打破理性投资者和市场效率模型:

- 首先,行为模型考虑到一些投资者是非理性的并且能够影响价格($\color{blue}{De\ Long\ et\ al.,\ 1990JPE}$)。诸如推断($\color{blue}{Tversky\ and\ Kahneman,\ 1983}$)和过度自信($\color{blue}{Fischhoff\ et\ al.,\ 1977}$)等偏差可能会导致非理性投资者增加对金融资产的需求,从而推动价格超出经济基本面。

- 其次,套利的限制阻止理性投资者全面、立即纠正价格偏离基本面的情况($\color{blue}{Pontiff,\ 1996QJE}$;$\color{blue}{Shleifer\ and\ Vishny,\ 1997JF}$)。行为模型的主要预测之一是市场回报反转:当积极(消极)情绪飙升时,非理性投资者将增加(减少)资产需求,推动价格远离基本水平。行为模型预测,需求的增加(减少)将导致更高(更低)的收益,随着市场修正至其基本水平,这种回报将随着时间的推移而反转。

News sentiment embedded in photos and text

本节讨论主要结果:

- 首先,证明照片中嵌入的悲观情绪预示着市场收益的反转,这与行为模型的预测一致($\color{blue}{De\ Long\ et\ al.,\ 1990JPE}$);

- 其次,研究照片中嵌入的悲观度如何与文本中嵌入的悲观度相互作用;

- 第三,探讨与文字相比,哪种类型的新闻内容通过照片更有效地传播;

- 第四,构建了三种现实世界的交易策略,以强调分析新闻照片的益处。

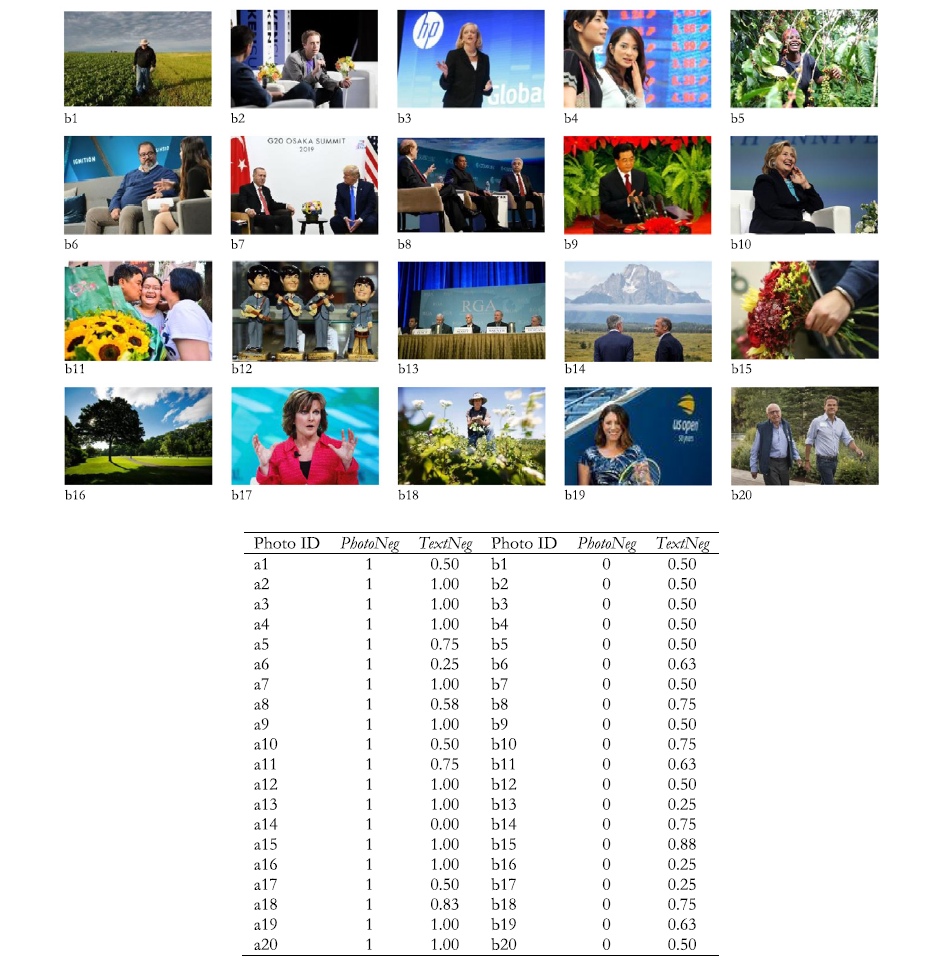

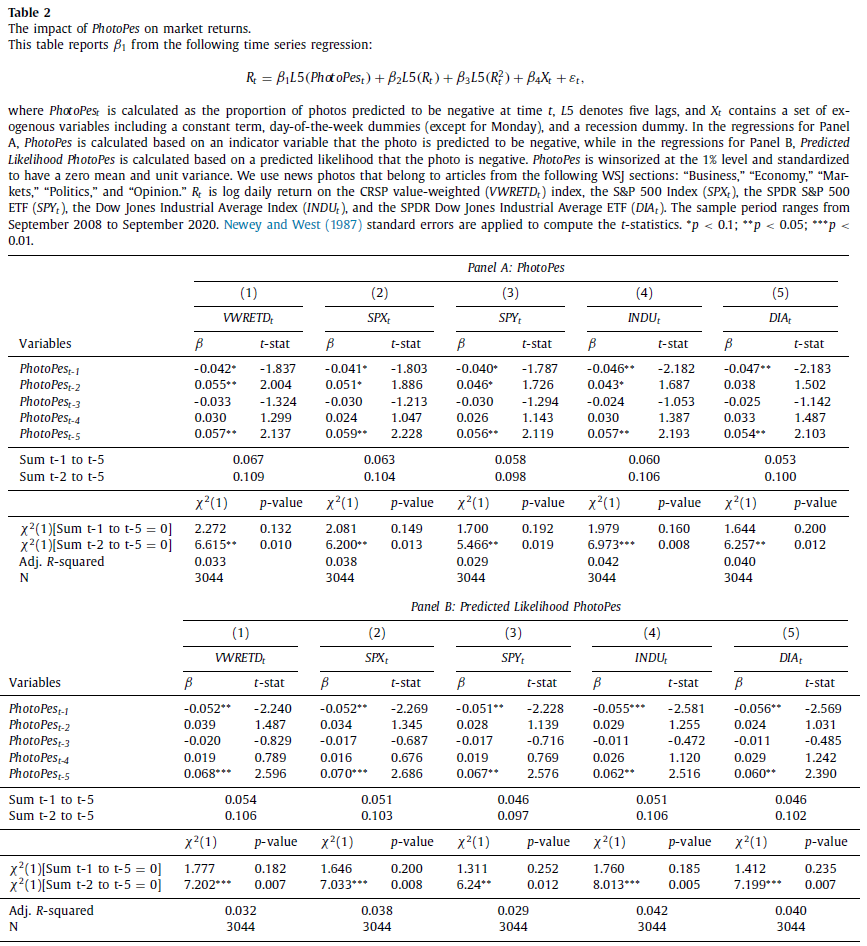

The impact of $PhotoPes$ on market returns

$\color{blue}{表2}$是$PhotoPes$对滞后的市场收益进行时间序列回归的主要结果,参考 $\color{blue}{Tetlock\ (2007JF)}$和$\color{blue}{Garcia\ (2013JF)}$00268-3/sbref0032)。具体而言,使用$\color{blue}{Newey\ and\ West\ (1987Econ)}$的$t$统计进行以下计算:

其中,$R{t}$表示日度对数收益<CRSP价值加权(VWRETD)指数、标普500指数 (SPX)、SPDR标普500ETF (SPY)、道琼斯工业平均指数(INDU)和SPDR道琼斯工业平均指数ETF(DIA)。 $PhotoPes$ 是在$t$时刻预测为负的照片比例;$L5$将变量转换为由该变量的五个滞后组成的行向量;$X{t}$是一组外生变量,包括截距、星期几指标(周一除外)以及时间$t$是否处于衰退期的指标变量。第$t-1$天的新闻情绪测量时间是基于第$t-1$天的新闻,这些新闻在$\color{red}{第t天上午发布并进入公共领域}$。除了主要股指之外,还检验了ETF,以确认结果不是由指数的非流动性成分驱动的($\color{blue}{Da\ et\ al.,\ 2015RFS}$)。

$\color{blue}{表2\ Panel\ A}$表明$PhotoPes_{t-1}$与市场收益均呈负相关。

- 经济意义:$PhotoPes$一个标准差变化对第二天的VWRETD的平均影响为$\color{red}{4.2bps}$,几乎是VWRETD无条件平均每日收益的大小(见$\color{blue}{表1\ Panel\ B}$ ,用于描述性统计);

- 检验$PhotoPes$的滞后性,以确定在接下来的四个交易日内是否会出现最初跌势的反转。反转集中在二阶滞后二和五阶滞后,交易周内的$\color{red}{反转幅度在9.8至10.9个基点之间}$。

- 卡方检验表明,反转($t-2$和$t-5$之间的系数之和)在INDU的1%水平以及VWRETD、SPX、SPY和DIA的5% 水平上具有统计显著性。此外,卡方检验显示,$t-1$和$t-5$之间的$PhotoPes$系数之和与零无法区分,这表明$t-1$时刻的初始下跌在交易周的剩余时间内发生反转。收益反转模式与悲观投资者造成的短暂价格下行压力一致。可以排除$PhotoPes$包含基本面信息的可能性,因为收益率最初下降之后是完全逆转。

一个重要的问题是news photos是否直接导致投资者变得更加悲观或不那么悲观?尽管不能排除新闻编辑选择照片来反映读者信念的可能性,但本文提供了一些证据表明新闻照片直接影响投资者的信念,研究了$PhotoPes$与顾问情绪报告的关系。“顾问情绪报告“调查了100多家独立投资通讯的市场观点,并将调查结果报告为看涨、看跌和预期调整的顾问的百分比。” 14本文对$PhotoPes$在$t-1$至$t-5$天的净看跌分数进行回归,发现$PhotoPes$预测下一个交易周的净看跌分数会增加。15这项测试表明,当新闻包含许多负面图片时,财务顾问在接下来的交易周会变得更加看跌和不那么看涨。

14:Source: https://www.investorsintelligence.com/x/advisors_sentiment.

15:The results are available upon request from the authors.

接下来,使用照片中负面情绪的预测可能性替换负面情绪指示变量$Neg{it}$进而修改$PhotoPes$。预测可能性是分类模型对于预测$t$天的照片$i$包含负面情绪的置信度;因此,修改后的$PhotoPes$将为照片分类模型更确定的照片赋予更高的权重。在$\color{blue}{表2\ Panel\ B}$中$PhotoPes{t-1}$与市场收益仍呈负相关,相较于$\color{blue}{Panel\ A}$中的基线结果,当使用修改后的$PhotoPes$时,经济规模和这种关系的统计显着性更强。注意:其余检验中仅使用未修改的$PhotoPes$。

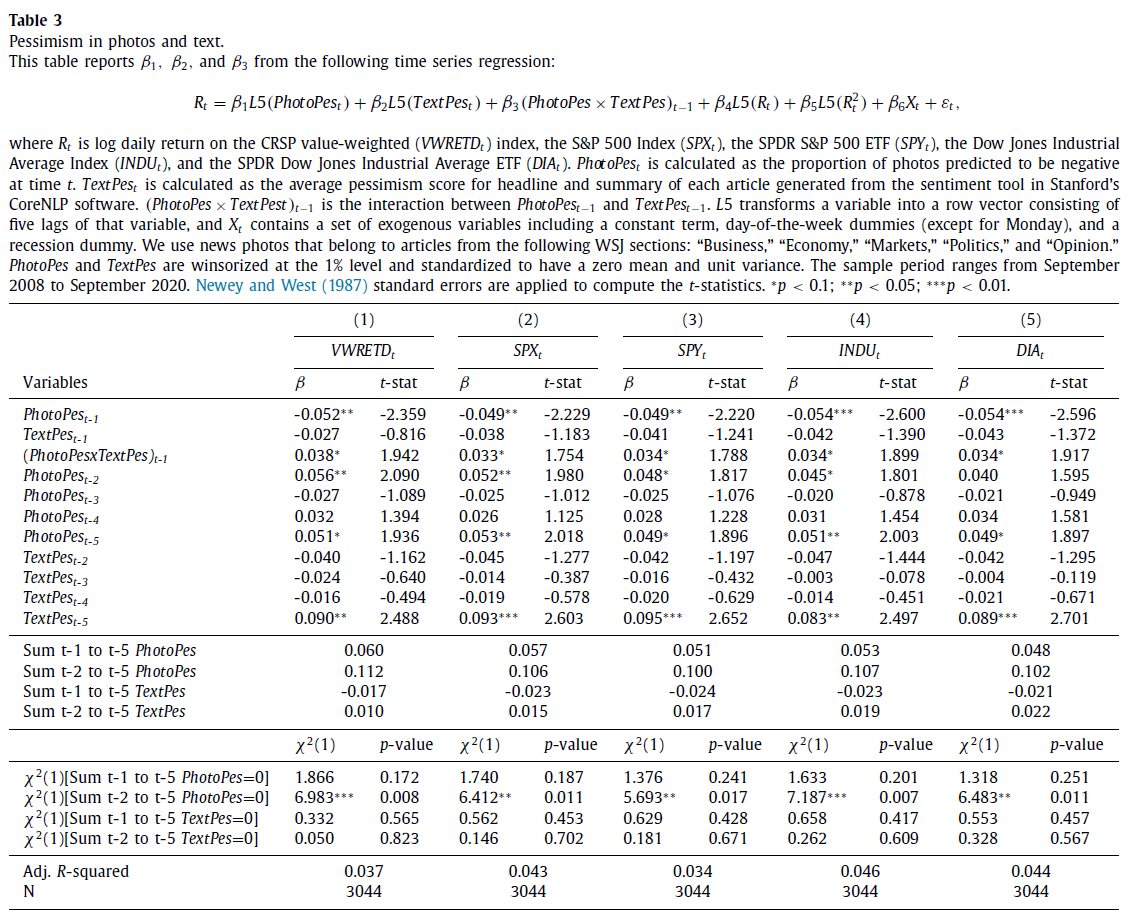

$PhotoPes$ and sentiment embedded in text

本节比较$PhotoPes$和$TextPes$的预测能力,以及照片和新闻文字是互补还是替代。具体而言,新闻媒体是否使用照片来enhance(complement)文本中嵌入的情感,或者是否使用照片来传达文本的alternative信息(substitutes)?鉴于新闻媒体日益多元化,这是一个需要解决的重要问题。

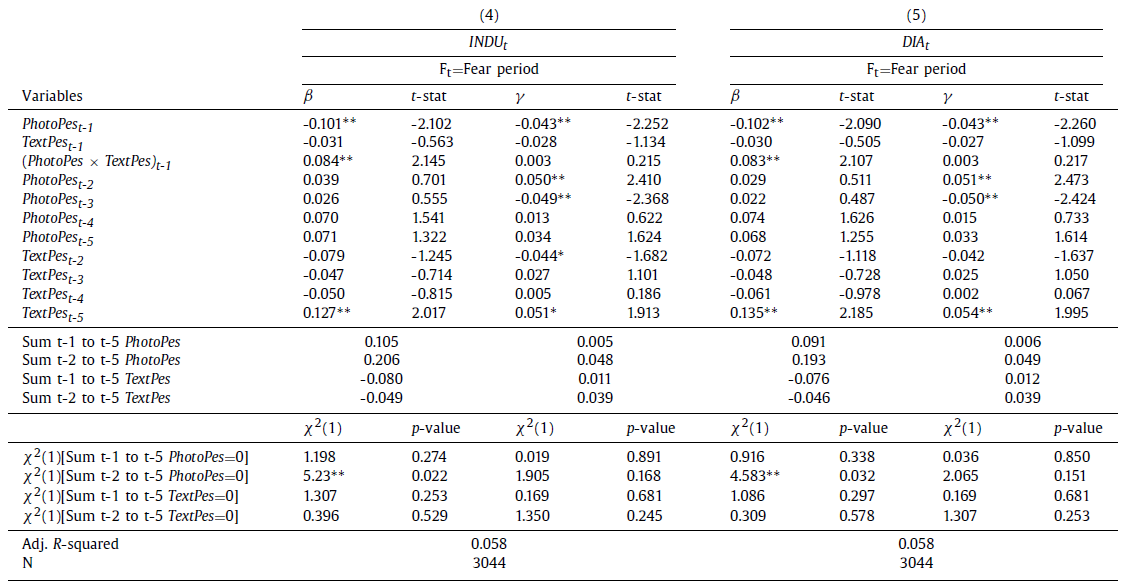

$\color{blue}{表3}$研究了$PhotoPes$、$TextPes$及其相互作用与市场回报的关系。运行以下回归:

其中$TextPes_{t}$是CoreNLP模型在时间$t$(在第 2.3 节中定义)所有文章的平均悲观得分。为了更好地理解这两个变量如何相互作用,本文基于相同的文章来计算$TextPes$和$PhotoPes$(即,在$TextPes$的计算中不包括没有照片的文章)。

$\color{blue}{表3}$中控制新闻文本中的悲观情绪后,$PhotoPes{t-1}$与VWRETD、SPX、SPY、INDU和DIA的市场回报呈负相关。尽管$\color{blue}{表4}$表明,**在不控制$PhotoPes$的情况下$TextPes$可以预测回报反转,但在将$PhotoPes$添加到模型中后,$\color{blue}{表3}$中$TextPe{t-1}$的系数为负,但在 10% 水平上不具有统计显著性*。【值得注意的是,在此回归中$TextPes$不显著的一个可能原因是我们仅基于带有照片的文章计算$TextPes$。当使用视觉信息而不是文本更强烈地传达主题时,新闻编辑可能会在文章中包含照片,从而有利于我们的$PhotoPes$变量。*】

接下来,考虑$PhotoPes$和$TextPes$交互项。通过交互项$(PhotoPes\times TextPes)_{t-1}$评估新闻变量中的悲观情绪对第二天收益的补充或替代效应,并研究一个悲观变量对次日收益率的边际效应取决于另一个悲观变量的水平($\color{blue}{Aiken\ et\ al.,\ 1991Book}$;$\color{blue}{Siggelkow,\ 2002MS}$)。

一方面,媒体可以使用照片来强化文本中的悲观情绪。如果照片中嵌入的悲观情绪增强了文本中嵌入的悲观情绪,那么当文本中嵌入的悲观情绪较高时,照片中高水平和低水平悲观情绪之间的收益边际下降应该更高,而不是更低。为支持互补这一观点,交互项系数 $(PhotoPes\times TextPes)_{t-1}$应为负。

另一方面,媒体可以使用照片来传达文本中尚未反映的投资者情绪的另一种维度。如果文本中嵌入的悲观情绪和照片中嵌入的悲观情绪作为替代品相互作用,那么当文本中嵌入的悲观情绪较高而不是较低时,照片中嵌入的悲观情绪的高水平和低水平之间的回报边际下降应该更小。换句话说,当$TextPes$水平较高时,在照片中嵌入额外的悲观情绪不会对市场回报产生显著的边际贡献。为支持替代这一观点,交互项系数 $(PhotoPes\times TextPes)_{t-1}$应为正。

- $\color{blue}{表3}$中系数均为正且在10%水平显著,支持替代假设16。

16:Interaction plots are available on request.

尽管控制$TextPes$,$PhotoPes$就占主导地位,但删除$PhotoPes$,仅$TextPes$就可以预测收益反转,从而证实了$\color{blue}{Tetlock\ (2007JF)}$和$\color{blue}{Garcia\ (2013JF)}$00268-3/sbref0032)的观点。

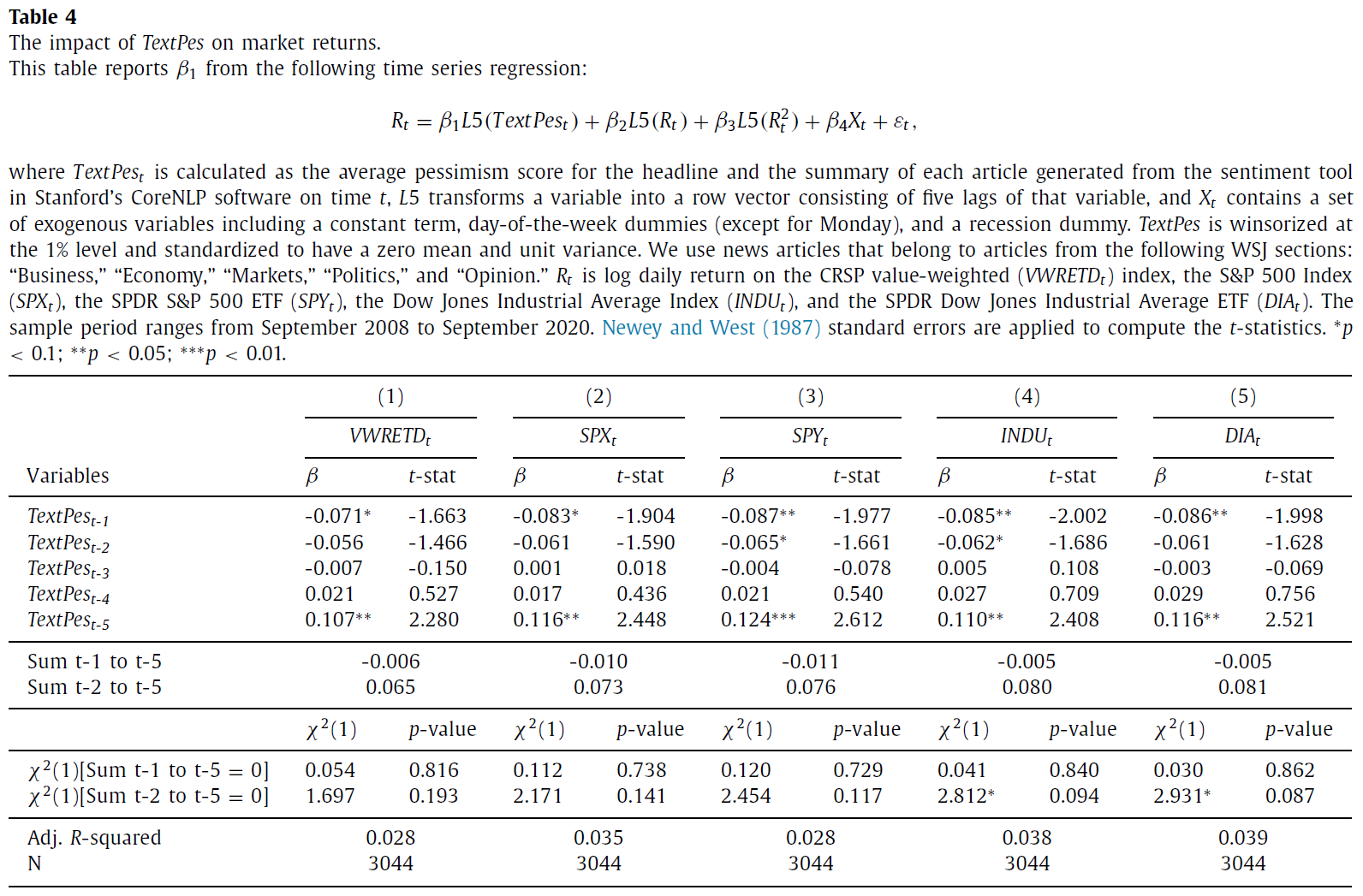

- $\color{blue}{表4}$报告了市场收益(VWRETD、SPX、SPY、INDU 和 DIA)对$TextPes$和对照滞后的时间序列回归结果(不控制$PhotoPes$且$\color{red}{不要求文章包含照片}$),$TextPes_{t-1}$与SPY、INDU和DIA在5%水平以及VWRETD和SPX在10%水平的市场收益负相关;

- 经济意义:$TextPes$的一个标准差变化对第二天INDU的平均影响为8.5bps,几乎是INDU无条件平均日收益率的2.2 倍。这一经济规模与$\color{blue}{Tetlock\ (2007JF)}$的报告一致(8.1bps);

- 此外,SPY和INDU的$t-2$系数仍然为负且显著,这表明与照片相比,市场需要更多时间反映新闻文本中的信息。$TextPes$的反转集中在$t-5$,而对于大多数规范,基线结果中$PhotoPes$的反转较早在$t-2$开始。对于INDU和DIA,$t-2$和$t-5$之间的反转幅度在8.0到8.1bps之间,并且在10%水平上具有统计显著性。考虑到规范1至3中$TextPes$的$t-2$和$t-5$之间缺乏显著反转,但所有规范中$t-5$处的显著正系数,得出结论:初始效果仅部分反转。

- 总体而言,这一结果与$TextPes$同时包含情绪和基本面信息相一致;因此,它与市场回报的关系只是$\color{red}{部分过渡性}$的。

Attention and $PhotoPes$

照片是否可以在报纸上发挥吸引注意力的作用?

唤起观众强烈情绪的照片可能会分散新闻文本的注意力,进而主导悲观-回归关系。研究表明,在新闻中加入照片可能会引人注目。例如,$\color{blue}{Garcia\ and\ Stark\ (1991Book)}$进行了一项眼球追踪研究,并记录了照片如何成为报纸页面最常见的最初吸引力。$\color{blue}{Powell\ et\ al.\ (2015JoC)}$发现了类似的证据,表明带有照片的文本内容或仅包含照片的内容比仅包含文本的内容更引人注目。在这些研究的推动下,本文检验了新闻中蕴含的悲观情绪与市场回报之间的关系如何根据显著新闻照片的存在而变化。

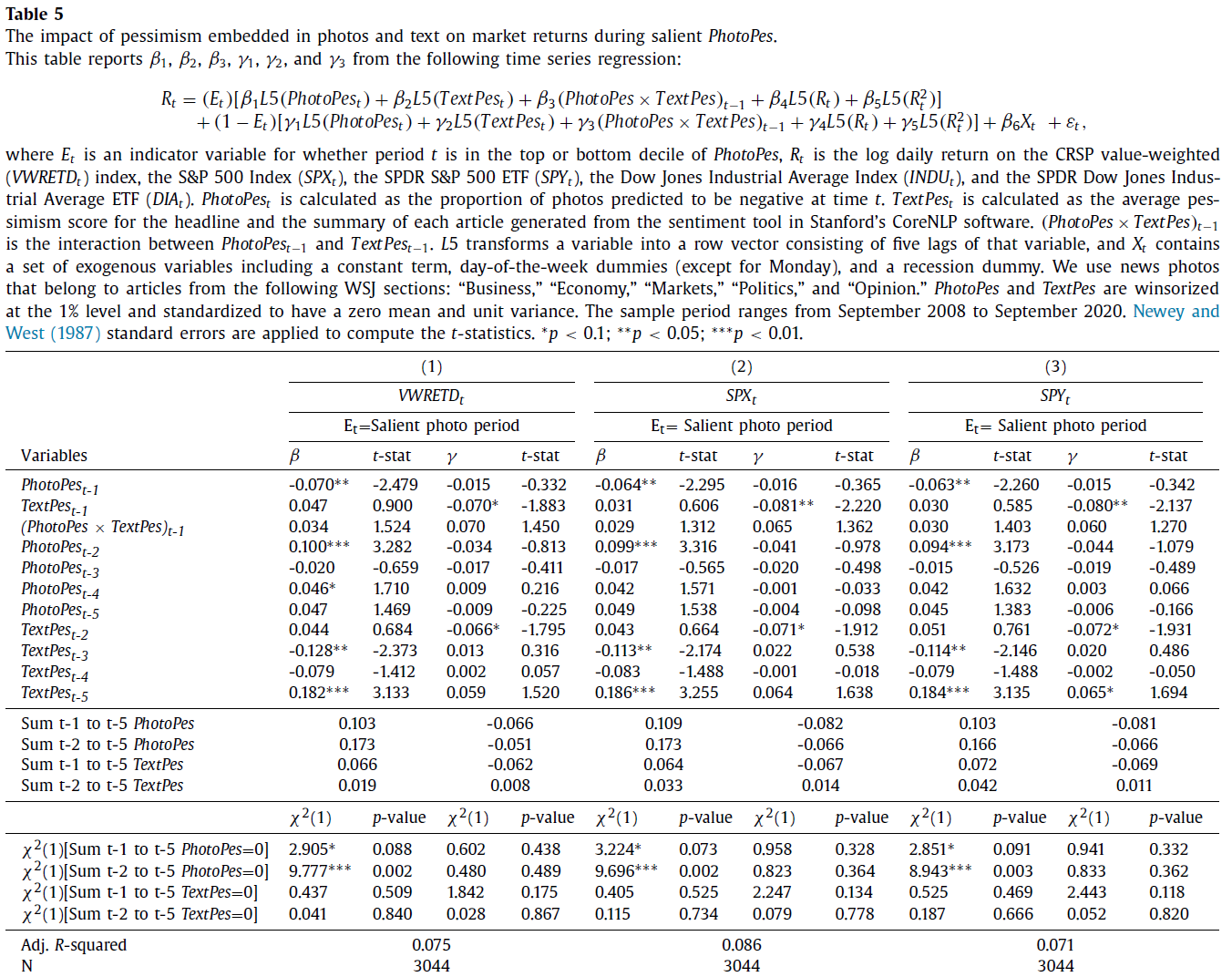

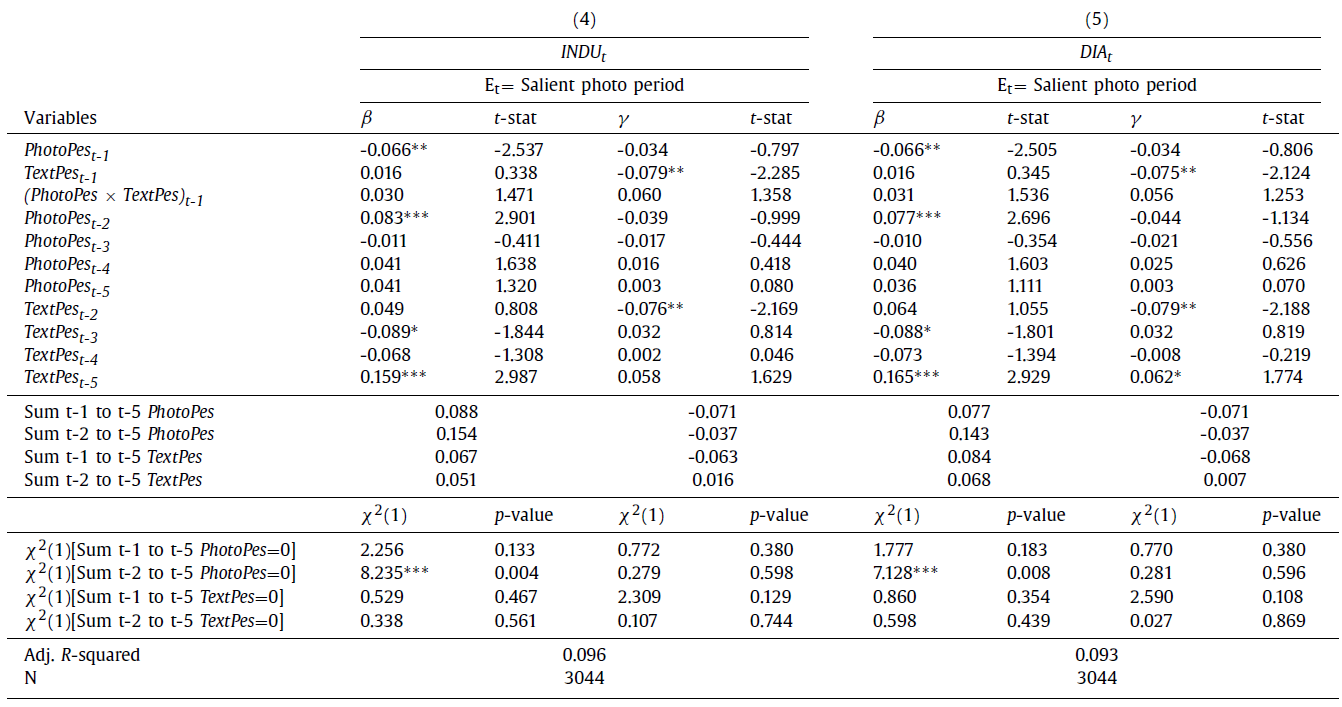

为检验新闻照片的吸引注意力的作用,运行以下回归区分$PhotoPes$和$TextPes$在照片突出期间对市场回报的影响:

其中$E{t}$是一个指示变量,如果$t$日位于$PhotoPes$的顶部或底部十分位数,则该变量的值为1。作者假设,当大多数照片具有相同的情绪(即照片绝大多数是正面或负面)时,$E{t}=1$,读者会发现照片中的一致信息很突出,因此会关注照片而不是文本。另一方面,当照片具有中性或混合情绪时,$E_{t}=0$,读者会发现照片中的混合信息较弱,因此会关注文本。

$\color{blue}{表5}$为假设提供支撑:

- 在5%水平上,$PhotoPes$在照片突出的时期与第二天的市场收益率负相关;

- 此外,在照片突出的时期,$TextPes$与第二天的市场收益在统计上没有相关性。

- 相比之下,在照片不显著的时期,$TextPes$与第二天的市场收益呈负相关,SPX、SPY、INDU和DIA的水平为5%,VWRETD的水平为10%。

- 此外,在照片不显著的时期,$PhotoPes$与第二天的市场回报没有显著相关。

总体而言,$\color{blue}{表5}$表明,在照片突出的日子里,$PhotoPes$占主导地位,而$TextPes$并不重要。相比之下,在照片不显著的日子里,$TextPes$占主导地位,而 $PhotoPes$则没有统计意义。照片可能会吸引整篇文章(包括文字)的注意力;然而,实证结果并不支持这种可能性,因为在照片显著(不显著)的时期,$TextPes_{t-1}$的系数是微不显著(显著)17。

17. 在未展示的结果中,记录了表5中的显著性效应是不对称的。在大多数照片都是正面的日子里,这种效果最强(最低的照片十分位数)。这一证据与Sicherman et al.(2015)一致,他们发现投资者具有选择性关注,在市场下跌期间,投资者对金融市场的关注度暴跌9.5%。当$PhotoPes$较高(负面照片较多)时,投资者对照片的关注较少,因此与$PhotoPes$较低的日子相比,效果较小。 ↩

Which information is more effectively transmitted by photos?

本文试图回答新闻照片捕捉到哪些文字无法捕捉到的信息。

先前的研究表明,照片可以成为捕捉创伤事件的更有效的媒介($\color{blue}{Chemtob\ et\ al.,\ 1999JTS}$)。作者检验了在恐惧加剧期间,市场收益与照片和文本中嵌入的悲观情绪之间的关系是否会发生变化。

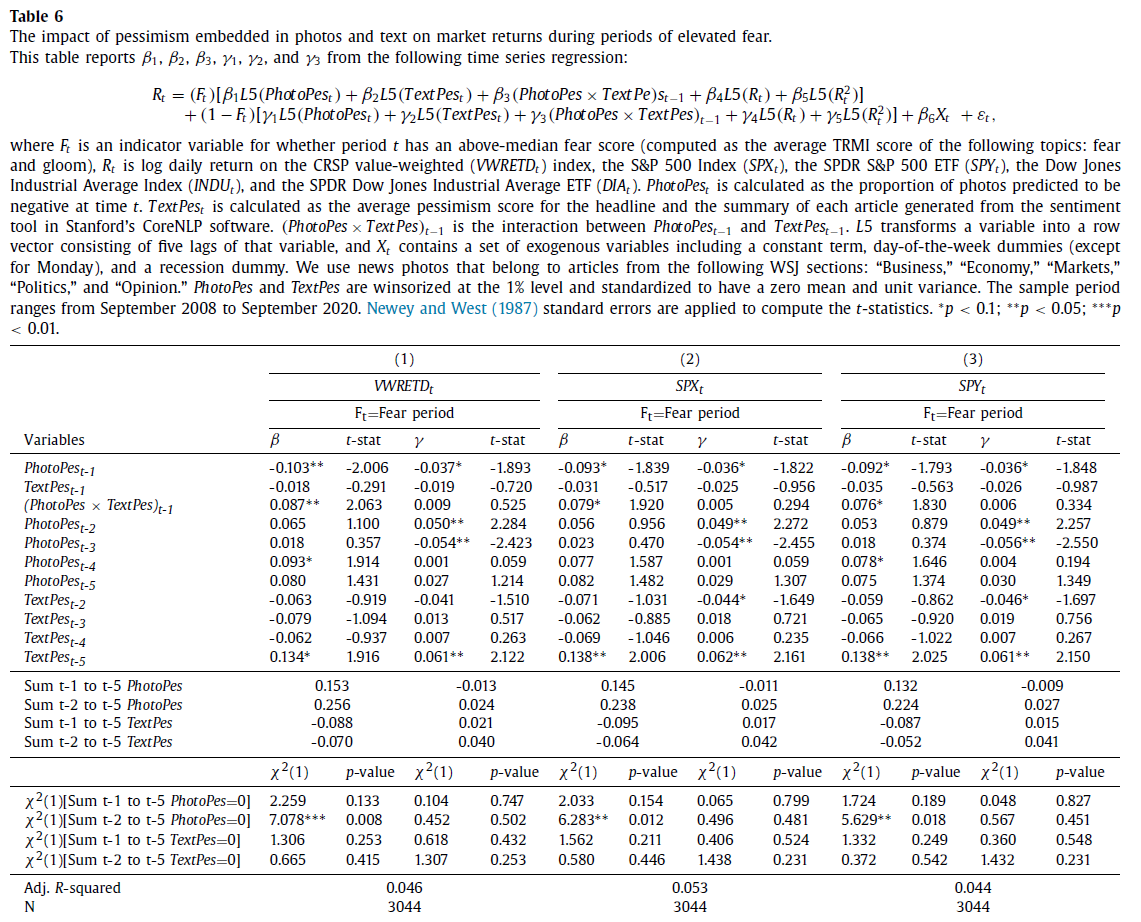

使用TRMI(汤森路透市场心理指数)指标衡量恐惧加剧的时期,这些指标从广泛的新闻媒体来源和社交媒体内容中捕捉不同主题和情绪的基调。TRMI使用专有字典对$t$天内不同情绪和事件的语气进行分类,并以0到1的等级进行量化;分数越高,事件或情绪越普遍。为检验使用文本和照片的新闻中的悲观情绪与恐惧水平的市场回报之间的关系,采用以下回归:

其中$F_{t}$是指示变量,如果$t$天的恐惧分数高于中位数(计算为以下主题的平均TRMI分数:fear and gloom),则该指标变量的值为 1。

$\color{blue}{表6}$五个规范中,无论恐惧程度高还是低,$PhotoPes{t-1}$都与市场回报呈负相关。然而,在高度恐惧期间,幅度要大得多:例如,在高度恐惧期间,$PhotoPes$的一个标准差变化对第二天VWRETD的平均影响为10.3 bps,而在低度恐惧期间仅为3.7 bps。但对于$TextPes$却并非如此。在所有规范中,$TextPes{t-1}$均为负值但并不显著,且在高或低恐惧水平期间,系数的大小相似18。

18. 好奇的读者可能会担心,$F_{t}$变量只是挑选出了$PhotoPes$较高的日子。这并不值得担心,因为TRMI的恐惧和忧郁得分与照片指数之间的相关性很低,而且不显著(相关性为-0.025,P值=0.16)。 ↩

总体而言,在恐惧程度较高的时期,照片中嵌入的悲观系数大约是恐惧程度较低时期的2.8倍,而$TextPes$的系数在这两个时期相似。这一证据表明,在传达恐惧或战争等创伤性事件方面,照片比文字更有效($\color{blue}{Chemtob\ et\ al.,\ 1999JTS}$)。

References

- Hirshleifer, D., & Shumway, T. (2003). Good day sunshine: Stock returns and the weather. The Journal of Finance, 58(3), 1009-1032.

- Edmans, A., Garcia, D., & Norli, Ø. (2007). Sports sentiment and stock returns. The Journal of Finance, 62(4), 1967-1998.

- Tetlock, P. C. (2007). Giving content to investor sentiment: The role of media in the stock market. The Journal of Finance, 62(3), 1139-1168.

- Spiegel, M. (2008). Forecasting the equity premium: Where we stand today. The Review of Financial Studies, 21(4), 1453-1454.

- Baker, M., & Wurgler, J. (2006). Investor sentiment and the cross‐section of stock returns. The Journal of Finance, 61(4), 1645-1680.

- Kozak, S., Nagel, S., & Santosh, S. (2018). Interpreting factor models. The Journal of Finance, 73(3), 1183-1223.

- Chemtob, C. M., Roitblat, H. L., Hamada, R. S., Muraoka, M. Y., Carlson, J. G., & Bauer, G. B. (1999). Compelled attention: The effects of viewing trauma‐related stimuli on concurrent task performance in posttraumatic stress disorder. Journal of Traumatic Stress: Official Publication of The International Society for Traumatic Stress Studies, 12(2), 309-326.

- Vissing-Jorgensen, A. (2003). Perspectives on behavioral finance: Does” irrationality” disappear with wealth? Evidence from expectations and actions. NBER macroeconomics annual, 18, 139-194.

- Singer, E. (2002). The use of incentives to reduce nonresponse in household surveys. Survey nonresponse, 51(1), 163-177.

- Mullainathan, S., & Spiess, J. (2017). Machine learning: an applied econometric approach. Journal of Economic Perspectives, 31(2), 87-106.

- Manela, A., & Moreira, A. (2017). News implied volatility and disaster concerns. Journal of Financial Economics, 123(1), 137-162.

- Buehlmaier, M. M., & Whited, T. M. (2018). Are financial constraints priced? Evidence from textual analysis. The Review of Financial Studies, 31(7), 2693-2728.

- Gu, S., Kelly, B., & Xiu, D. (2020). Empirical asset pricing via machine learning. The Review of Financial Studies, 33(5), 2223-2273.

- Feng, G., Giglio, S., & Xiu, D. (2020). Taming the factor zoo: A test of new factors. The Journal of Finance, 75(3), 1327-1370.

- Shiller, R. J. (2015). Irrational exuberance: Revised and expanded third edition. In Irrational exuberance. Princeton university press.

- Garcia, D. (2013). Sentiment during recessions. The Journal of Finance, 68(3), 1267-1300.

- De Long, J. B., Shleifer, A., Summers, L. H., & Waldmann, R. J. (1990). Noise trader risk in financial markets. Journal of Political Economy, 98(4), 703-738.

- Pontiff, J. (1996). Costly arbitrage: Evidence from closed-end funds. The Quarterly Journal of Economics, 111(4), 1135-1151.

- Shleifer, A., & Vishny, R. W. (1997). The limits of arbitrage. The Journal of Finance, 52(1), 35-55.

- Chemtob, C. M., Roitblat, H. L., Hamada, R. S., Muraoka, M. Y., Carlson, J. G., & Bauer, G. B. (1999). Compelled attention: The effects of viewing trauma‐related stimuli on concurrent task performance in posttraumatic stress disorder. Journal of Traumatic Stress: Official Publication of The International Society for Traumatic Stress Studies, 12(2), 309-326.

- Zhou, G. (2018). Measuring investor sentiment. Annual Review of Financial Economics, 10, 239-259.

- Da, Z., Engelberg, J., & Gao, P. (2015). The sum of all FEARS investor sentiment and asset prices. The Review of Financial Studies, 28(1), 1-32.

- Chen, H., De, P., Hu, Y., & Hwang, B. H. (2014). Wisdom of crowds: The value of stock opinions transmitted through social media. The review of financial studies, 27(5), 1367-1403.

- Loughran, T., & McDonald, B. (2011). When is a liability not a liability? Textual analysis, dictionaries, and 10‐Ks. The Journal of Finance, 66(1), 35-65.

- Jiang, F., Lee, J., Martin, X., & Zhou, G. (2019). Manager sentiment and stock returns. Journal of Financial Economics, 132(1), 126-149.

- Hirshleifer, D., & Shumway, T. (2003). Good day sunshine: Stock returns and the weather. The Journal of Finance, 58(3), 1009-1032.

- Hirshleifer, D. (2001). Investor psychology and asset pricing. The journal of Finance, 56(4), 1533-1597.

- Shiller, R. J. (2015). Irrational exuberance: Revised and expanded third edition. In Irrational exuberance. Princeton university press.

- Mullainathan, S., & Shleifer, A. (2005). The market for news. American Economic Review, 95(4), 1031-1053.

- Gentzkow, M., & Shapiro, J. M. (2010). What drives media slant? Evidence from US daily newspapers. Econometrica, 78(1), 35-71.

- Nelson, D. L., Reed, V. S., & Walling, J. R. (1976). Pictorial superiority effect. Journal of Experimental Psychology: Human Learning and Memory, 2(5), 523.

- Paivio, A. (1991). Images in mind: the evolution of a theory. Harvester Wheatsheaf.

- Newhagen, J. E., & Reeves, B. (1992). The evening’s bad news: Effects of compelling negative television news images on memory. Journal of Communication, 42(2), 25-41.

- Garcia, M., Stark, P. (1991). Eyes On the News. Poynter Institute for Media Studies, St. Petersburg, FL.

- Powell, T. E., Boomgaarden, H. G., De Swert, K., & De Vreese, C. H. (2015). A clearer picture: The contribution of visuals and text to framing effects. Journal of Communication, 65(6), 997-1017.

- Chaiken, S., & Eagly, A. H. (1976). Communication modality as a determinant of message persuasiveness and message comprehensibility. Journal of Personality and Social Psychology, 34(4), 605.

- Todorov, A., Mandisodza, A. N., Goren, A., & Hall, C. C. (2005). Inferences of competence from faces predict election outcomes. Science, 308(5728), 1623-1626.

- Duarte, J., Siegel, S., & Young, L. (2012). Trust and credit: The role of appearance in peer-to-peer lending. The Review of Financial Studies, 25(8), 2455-2484.

- Halford, J. T., & Hsu, H. C. S. (2020). Beauty is wealth: CEO attractiveness and firm value. Financial Review, 55(4), 529-556.

- Graham, J. R., Harvey, C. R., & Puri, M. (2017). A corporate beauty contest. Management Science, 63(9), 3044-3056.

- Bazley, W. J., Cronqvist, H., & Mormann, M. (2021). Visual finance: The pervasive effects of red on investor behavior. Management science, 67(9), 5616-5641.

- Blankespoor, E., Hendricks, B. E., & Miller, G. S. (2017). Perceptions and price: Evidence from CEO presentations at IPO roadshows. Journal of Accounting Research, 55(2), 275-327.

- Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). Imagenet classification with deep convolutional neural networks. Advances in Neural Information Processing Systems, 25.

- Yu, J., Wang, Z., Majumdar, A., & Rajagopal, R. (2018). DeepSolar: A machine learning framework to efficiently construct a solar deployment database in the United States. Joule, 2(12), 2605-2617.

- Scoles, S. , 2019. Researchers spy signs of slavery from space. Science 363(6429), 804.

- Jean, N., Burke, M., Xie, M., Davis, W. M., Lobell, D. B., & Ermon, S. (2016). Combining satellite imagery and machine learning to predict poverty. Science, 353(6301), 790-794.

- You, Q., Luo, J., Jin, H., & Yang, J. (2015, February). Robust image sentiment analysis using progressively trained and domain transferred deep networks. In Proceedings of the AAAI conference on Artificial Intelligence (Vol. 29, No. 1).

- Szegedy, C., Vanhoucke, V., Ioffe, S., Shlens, J., & Wojna, Z. (2016). Rethinking the inception architecture for computer vision. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 2818-2826).

- Yang, L., Hanneke, S., & Carbonell, J. (2013). A theory of transfer learning with applications to active learning. Machine Learning, 90, 161-189.

- Campos, V., Jou, B., & Giro-i-Nieto, X. (2017). From pixels to sentiment: Fine-tuning CNNs for visual sentiment prediction. Image and Vision Computing, 65, 15-22.

- Cong, L. W., Liang, T., & Zhang, X. (2019). Textual factors: A scalable, interpretable, and data-driven approach to analyzing unstructured information. Interpretable, and Data-driven Approach to Analyzing Unstructured Information (September 1, 2019).

- Socher, R., Perelygin, A., Wu, J., Chuang, J., Manning, C. D., Ng, A. Y., & Potts, C. (2013, October). Recursive deep models for semantic compositionality over a sentiment treebank. In Proceedings of the 2013 conference on empirical methods in natural language processing (pp. 1631-1642).

- Tversky, A., & Kahneman, D. (1983). Extensional versus intuitive reasoning: The conjunction fallacy in probability judgment. Psychological Review, 90(4), 293.

- Fischhoff, B., Slovic, P., & Lichtenstein, S. (1977). Knowing with certainty: The appropriateness of extreme confidence. Journal of Experimental Psychology: Human perception and performance, 3(4), 552.

- Newey, W.K., West, K.D., 1987. A simple, positive semi-definite, heteroskedasticity and autocorrelation consistent covariance matrix. Econometrica 55, 703-708.

- Aiken, L. S., West, S. G., & Reno, R. R. (1991). Multiple regression: Testing and interpreting interactions. sage.

- Siggelkow, N. (2002). Misperceiving interactions among complements and substitutes: Organizational consequences. Management science, 48(7), 900-916.

- Sicherman, N., Loewenstein, G., Seppi, D. J., & Utkus, S. P. (2016). Financial attention. The Review of Financial Studies, 29(4), 863-897.